Políticos diciendo groserías sobre sus contrincantes que nunca pronunciaron, líderes religiosos supuestamente renegando contra sus creencias y estrellas de Hollywood apareciendo en videos pornográficos que no grabaron.

Todas esas opciones son viables gracias a los “deep fakes”, una tecnología que emplea herramientas de reconocimiento facial e inteligencia artificial para tomar el rostro de un individuo y ponerlo sobre el de alguien más.

Con esta tecnología se puede grabar a una persona diciendo o haciendo lo que sea y que parezca que es en realidad un personaje público. Por ejemplo, el expresidente estadounidense, Barack Obama.

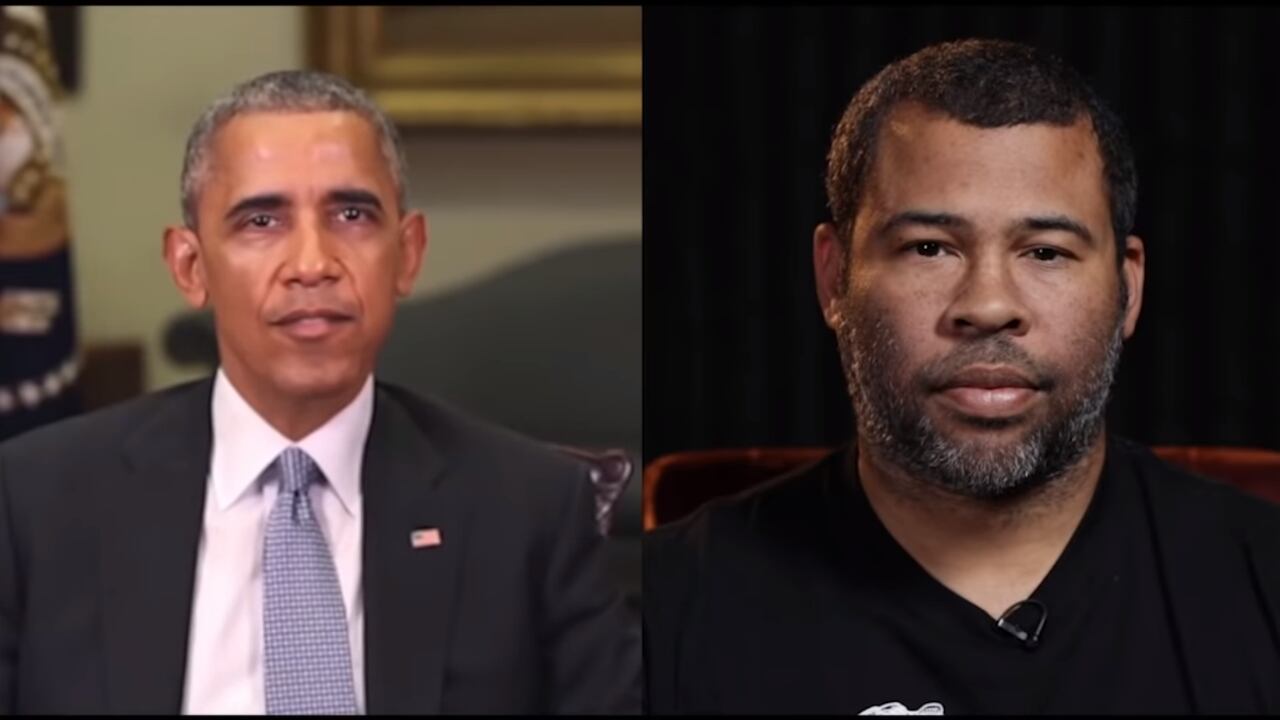

En 2018, el medio de comunicación estadounidense BuzzFeed creó un “deep fake” de Obama, con el cual buscaba concienciar sobre los peligros que acarrea esa tecnología en la era de la desinformación.

En el video se ve al exmandatario aclarando cómo funcionan los “deep fakes” y diciendo insultos contra varios políticos estadounidenses, incluyendo el presidente actual, Donald Trump.

“El presidente Trump es un total y completo idiota”, afirma, aparentemente, Obama en el audiovisual, que luego muestra cómo las palabras en realidad fueron pronunciadas por el actor Jordan Peele.

Aunque el video pretendía alertar sobre los alcances que puede tener esta tecnología, en realidad terminó impulsando a muchos creadores de contenido a utilizar herramientas audiovisuales para elaborar material engañoso y de burla.

Uno de los ejemplos más virales de la red fue el del actor Nicolas Cage, ya que con un uso bastante rudimentario de los “deep fakes”, tomaron su imagen y la pusieron sobre el rostro de otros actores en escenas de películas famosas.

El tipo de montaje realizado en los videos de Cage es el más clásico para crear “deep fakes”, pero también es el más fácil de detectar, ya que el procedimiento se consigue, simplemente, colocando un video sobre otro, razón por la que el resultado no siempre es de calidad.

La diferencia entre los videos de Cage y el de Obama es que los avances en reconocimiento facial y en inteligencia artificial hacen prácticamente imposible detectar que el rostro del exmandatario era falso.

LEA MÁS: La desinformación también ataca desde Instagram, el ejemplo de las elecciones en EE. UU.

Propio del cine

Los primeros usos de esta tecnología estuvieron ligados a la industria cinematográfica. Un ejemplo de este avance fue la película “Star Wars: Rogue One” (2016), en la cual se empleó el reconocimiento facial para recrear los rostros de personajes que aparecieron en la cinta “Star Wars: A New Hope″ (1977).

La pornografía es otro de los negocios que por años buscó perfeccionar las técnicas de edición, para hacer creer que estrellas de Hollywood aparecieron en videos pornográficos.

Un caso reciente en que se empleó “deep fakes” se presentó en 2018, cuando circuló un supuesto video pornográfico de la actriz Scarlett Johansson.

"Nada puede impedir que alguien corte y pegue mi imagen o la de otra persona en otro cuerpo y haga que se vea tan realista como desee”, dijo la actriz al ‘Washington Post’ sobre el tema.

¿Indefensos?

De momento, no existen herramientas que permitan detectar “deep fakes” tan elaborados como el de Barack Obama. Sin embargo, esa complejidad sería la única protección de los usuarios, ante los fines desinformativos que se le pueden dar a esta tecnología.

Para que uno de estos video falsos sea realmente imposible de diferenciar de uno verdadero se necesita, al menos, un manejo avanzado de herramientas de reconocimiento facial y edición, así como de actores que logren una interpretación creíble.

El actor que vaya a realizar la interpretación tiene que estudiar meticulosamente al individuo que se va a suplantar, analizar sus gestos, cómo habla, cómo respira e incluso, cuánto pestañea.

Además, se vuelve vital tener grandes cantidades de material audiovisual del individuo que será imitado para lograr una captura facial exacta con el uso de inteligencia artificial.

Esta información forma parte del proyecto #NoComaCuento, una iniciativa de La Nación que busca analizar la veracidad de la información circula en redes sociales. Usted puede formar parte de este proyecto enviándonos información que le parezca falsa o poco confiable al WhatsApp 6420-7160 o al correo nocomacuento@nacion.com.

También puede recibir nuestras publicaciones directamente en su celular uniéndose a este grupo de WhatsApp o al bot de Telegram.